词嵌入矩阵是NLP的基石,其应用场景已从基础NLP任务扩展到各行各业。

词嵌入矩阵是自然语言处理中的核心组件,其核心作用是将离散的符号(如单词、字符)转换为连续的、稠密的向量表示,从而捕捉语义和语法信息。词嵌入矩阵广泛应用于文本分类、情感分析、机器翻译、问答系统、推荐系统等领域。 更多

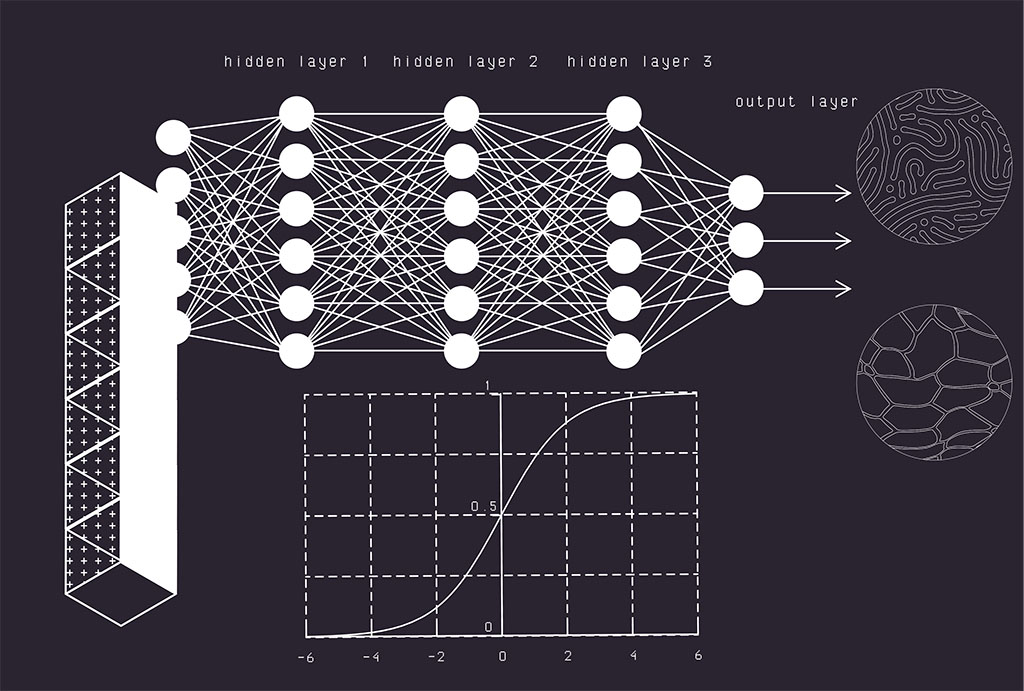

从传统的机器学习算法,到深度学习算法建模,QkCalc提供可视化的建模途径

从传统的机器学习算法,到深度学习算法建模,QkCalc提供可视化的界面,协助用户建立样本、通过算法训练样本、评估训练结果和建立模型。与其他符号计算一样,AI算法的计算过程同样可以获取计算步骤信息,让你对算法过程了如指掌,从而获取优化算法的最佳测试途径。

理解传统机器学习是深度学习的基础,很多实际问题,用简单的逻辑回归或随机森林就能完美解决,且速度更快、更易解释。无需动用复杂的深度学习模型。QkCalc提供传机器学习算法的建模,用户通过QkCalc图形界面建立样本、训练并调整参数。所有机器学习算法详细的求解步骤和算法说明文档。

用一个线性模型(一条直线或一个超平面)来描述一个或多个自变量(特征)与一个因变量(目标)之间的关系。并通过学习到的模型,对新的输入进行预测。

多元线性回归是简单线性回归的自然扩展,用于处理多个自变量 对一个因变量的影响。它在现实中应用更为广泛,因为任何结果通常都是由多种因素共同决定的。

是经典的分类算法,尤其是二分类算法。它的底层机制是使用了一个“回归”模型(线性加权和)来预测一个事件的对数几率。逻辑回归的核心思想在于解决一个问题:如何将一个线性回归的输出(值域为(-∞, +∞))变成一个表示概率的值(值域为[0, 1])?

线性判别分析是一种非常经典且强大的方法,它既有降维的能力,也常用于分类。理解LDA的关键在于把握其与逻辑回归和主成分分析(PCA)在思想上的区别。

决策树的核心思想是通过一系列的“如果...那么...”问题对数据进行递归分割,最终形成一个树形结构。这个结构非常像我们日常做决策的过程。

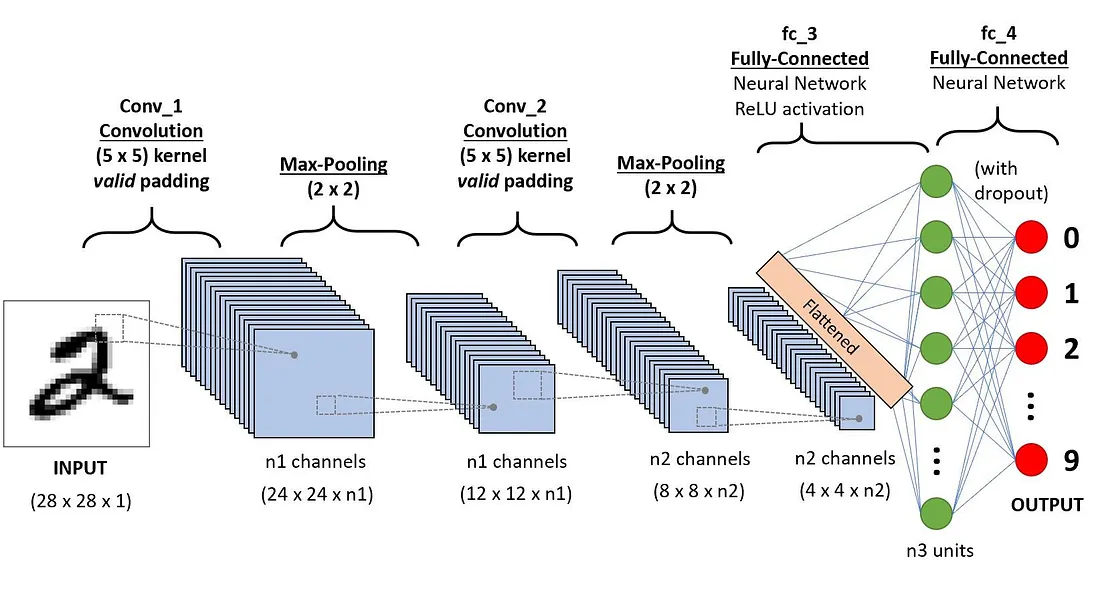

卷积神经网络(Convolutional Neural Network,简称CNN)是一种专为处理具有类似网格结构的数据(尤其是图像)而设计的深度学习模型。它的名字来源于其核心操作——卷积。在QkCalc中,可视化的卷积网络设计器,用户可以在设计视图中通过鼠标拖拽加入CNN网络所需要的层,并设置层的属性。通过在各个层之间建立链接来建立一个完整的CNN网络。此外,用户通过将训练结果导出并进行模型预测和测试。通过QkCalc中的CNN设计视图可以加快CNN网络算法设计并测试,并快速进行优化。它可用于: